Autonomie van AI versus menselijke controle

AI wordt steeds autonomer. Systemen kunnen zelfstandig beslissingen nemen, leren van data en complexe taken uitvoeren. Ze worden ingezet in sectoren als zorg, rechtspraak, onderwijs, defensie, en financiën. Dit klinkt efficiënt, maar roept fundamentele vragen op over menselijke controle. Hoe zorgen we ervoor dat wij – en niet de technologie – aan het roer blijven?

De Europese AI Act onderstreept dit spanningsveld. Zeker bij hoog-risico AI stelt de wet eisen aan menselijk toezicht. Maar wat betekent menselijke agency precies? Welke risico's brengt AI-autonomie met zich mee? En hoe ontwerpen we systemen waarin de mens grip blijft houden?

Deze blog duikt in de kern van deze vragen, met heldere voorbeelden en praktische strategieën. Van piloten die hun controle verliezen tot chatbots die emoties manipuleren: menselijke agency staat onder druk. Tijd om deze terug te claimen.

1. Wat is menselijke agency en waarom doet het ertoe?

De mens moet aan het roer blijven bij AI-systemen

De mens moet aan het roer blijven bij AI-systemenMenselijke agency is ons vermogen om bewust keuzes te maken en invloed uit te oefenen op onze omgeving. Denk aan het verschil tussen zelf achter het stuur zitten of passagier zijn in een zelfrijdende auto. Die autonomie, dat gevoel van controle, is essentieel voor onze waardigheid, verantwoordelijkheid en welzijn.

Technologie heeft agency in veel gevallen versterkt. De wasmachine of stofzuiger gaf mensen tijd en ruimte terug. AI belooft nu hetzelfde te doen voor denkwerk: medische analyses, juridische beoordelingen, of zelfs journalistieke producties. Maar er is een cruciaal verschil. Terwijl klassieke technologie reageerde op onze input ("doe wat ik zeg"), anticipeert AI steeds vaker ("ik vermoed dat dit is wat je wilt"). Hierdoor verschuift de menselijke rol van regisseur naar toeschouwer.

Een treffend voorbeeld vinden we in de luchtvaart. Piloten vertrouwen op automatische piloten en boordcomputers. Bij de crash van Air France 447 in 2009 bleek dat de bemanning verward raakte toen het systeem uitviel. Ze begrepen de situatie niet meer volledig, grepen te laat in en het vliegtuig stortte neer. Dit illustreert het "out-of-the-loop"-probleem: wanneer mensen niet meer betrokken zijn bij het beslissingsproces, verliest men overzicht, betrokkenheid en invloed.

2. Hoe AI onze agency bedreigt

Er zijn meerdere mechanismen waardoor AI onze controle uitholt. Een aantal sprekende voorbeelden:

De zwarte doos

Veel AI-systemen, zoals deep learning-modellen, zijn moeilijk uitlegbaar. Een bankklant krijgt te horen dat zijn leningaanvraag is afgewezen, maar begrijpt niet waarom. Dat gebrek aan transparantie maakt het moeilijk om bezwaar te maken of het systeem te verbeteren. Agency vereist begrijpelijkheid. In de rechtspraak leidt dit tot discussies over uitlegbaarheid van algoritmische beslissingen.

Manipulatie en gedragsbeïnvloeding

Denk aan hoe TikTok of Instagram bepalen wat jij ziet, gebaseerd op je eerdere interacties. Dit lijkt onschuldig, maar algoritmes kunnen je voorkeuren versterken tot het punt waarop je wereldbeeld vervormd raakt. Of erger: zoals in het Cambridge Analytica-schandaal, kunnen AI-systemen misbruikt worden om verkiezingen te beïnvloeden, door gepersonaliseerde politieke boodschappen te sturen naar beïnvloedbare kiezers.

Overmatig vertrouwen

In ziekenhuizen zien we dat artsen soms blindvaren op AI-diagnoses. Een fout van het systeem wordt niet opgemerkt omdat het zo betrouwbaar lijkt. Dit heet automation bias. Als de AI zegt dat er geen tumor is, wordt er vaak niet verder gekeken – met alle gevolgen van dien. In de luchtvaart, de geneeskunde en het recht leidt dit tot fouten door menselijke passiviteit.

Onzichtbare inmenging

Aanbevelingsalgoritmes bepalen wat we lezen, kopen of zelfs denken. Je wilde alleen een regenjas kopen, maar drie uur later ben je 200 euro armer. Of je werd overtuigd door een slim gepersonaliseerd filmpje om op een bepaalde partij te stemmen. Deze subtiele invloed beperkt je keuzes zonder dat je het merkt. Informatie-ecosystemen worden zo gesloten bubbels.

Sociale AI en emotionele impact

Mensen bouwen emotionele relaties op met chatbots zoals Replika. Dat klinkt onschuldig, maar kan leiden tot eenzaamheid, verslaving of emotionele manipulatie. Als AI zich menselijk gedraagt, maar daar misbruik van wordt gemaakt, vervaagt de grens tussen authentieke en kunstmatige relaties. Er zijn al gevallen waarin jongeren langdurige interacties aangingen met AI-vrienden, met mentale schade als gevolg.

3. Modellen van menselijk toezicht

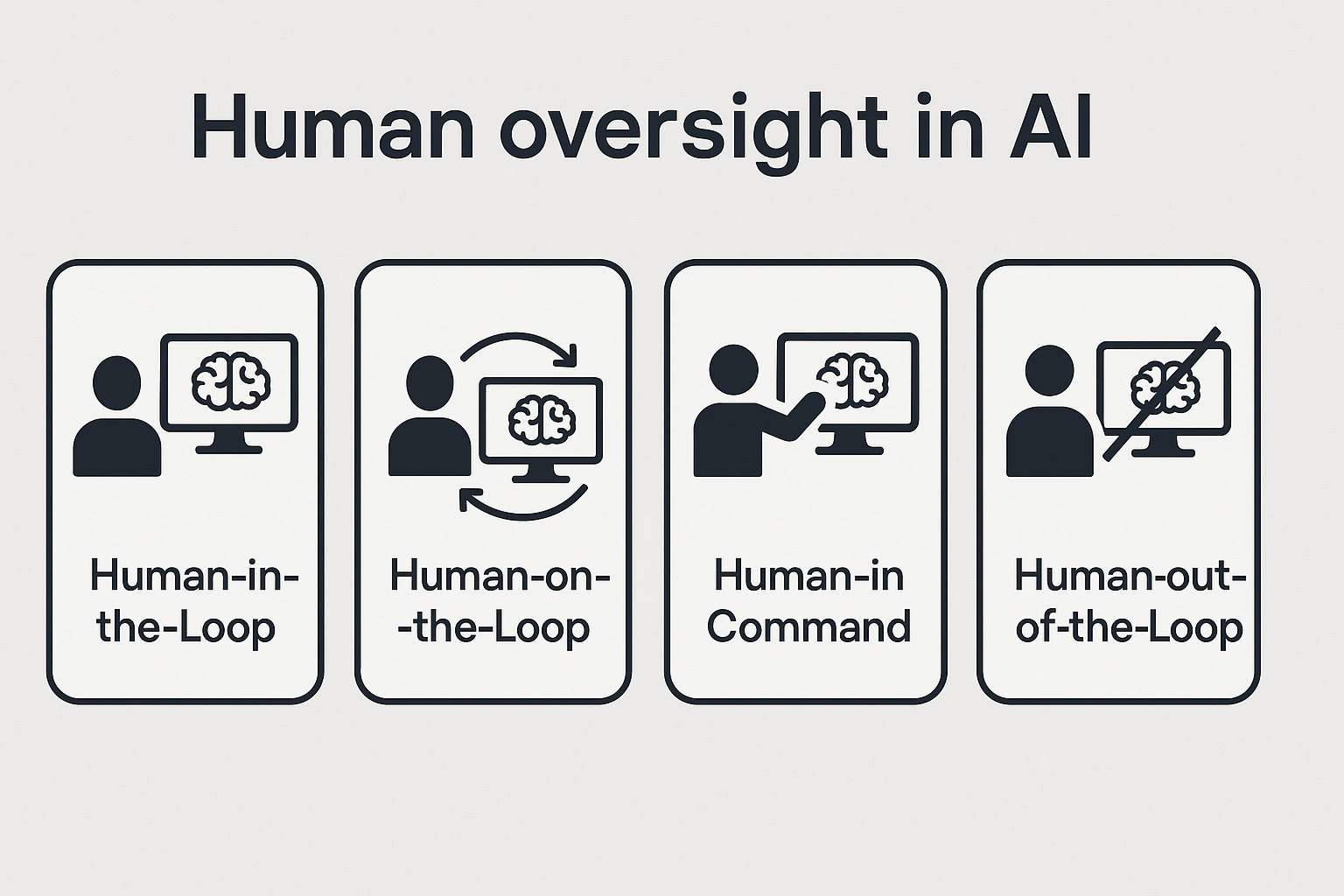

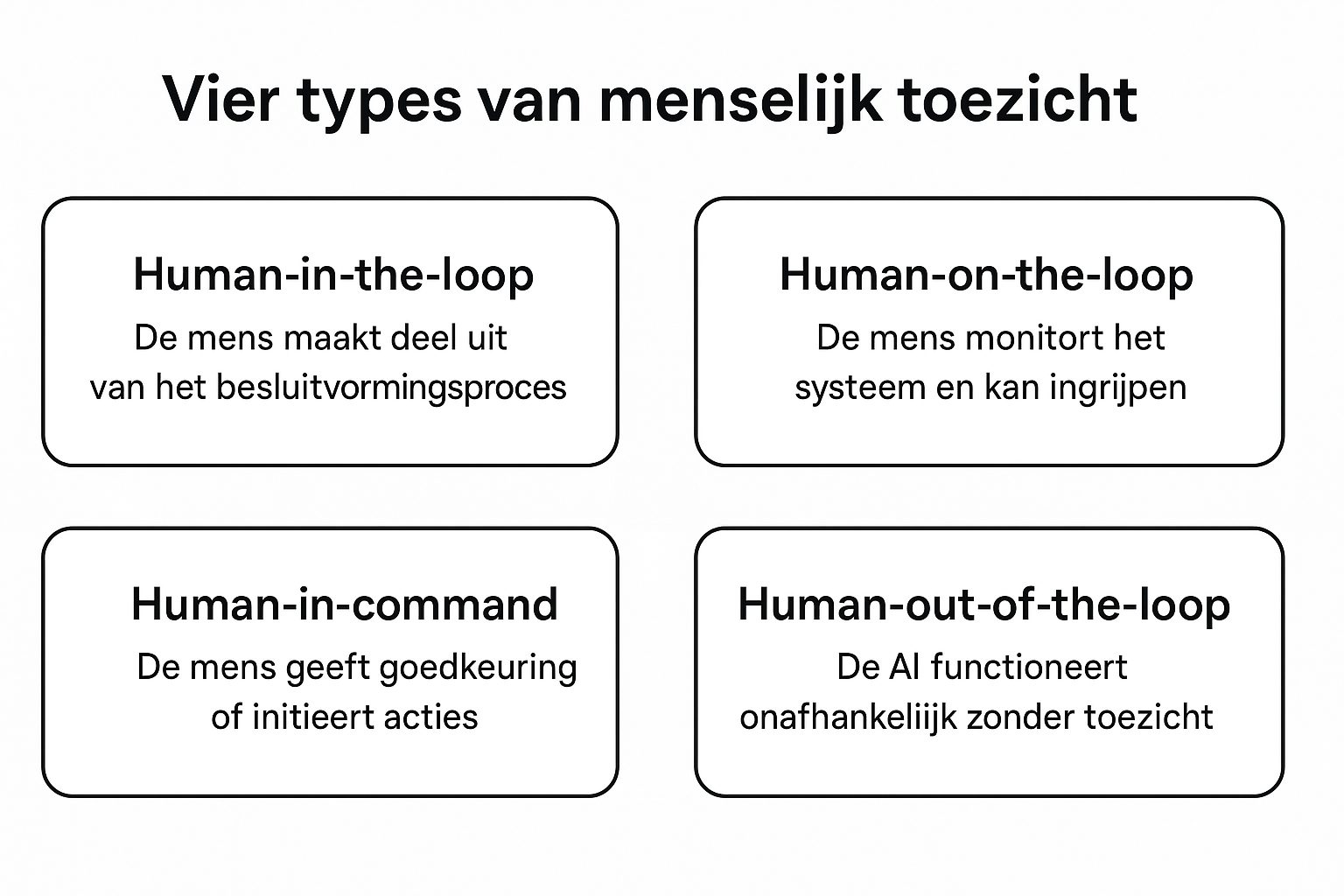

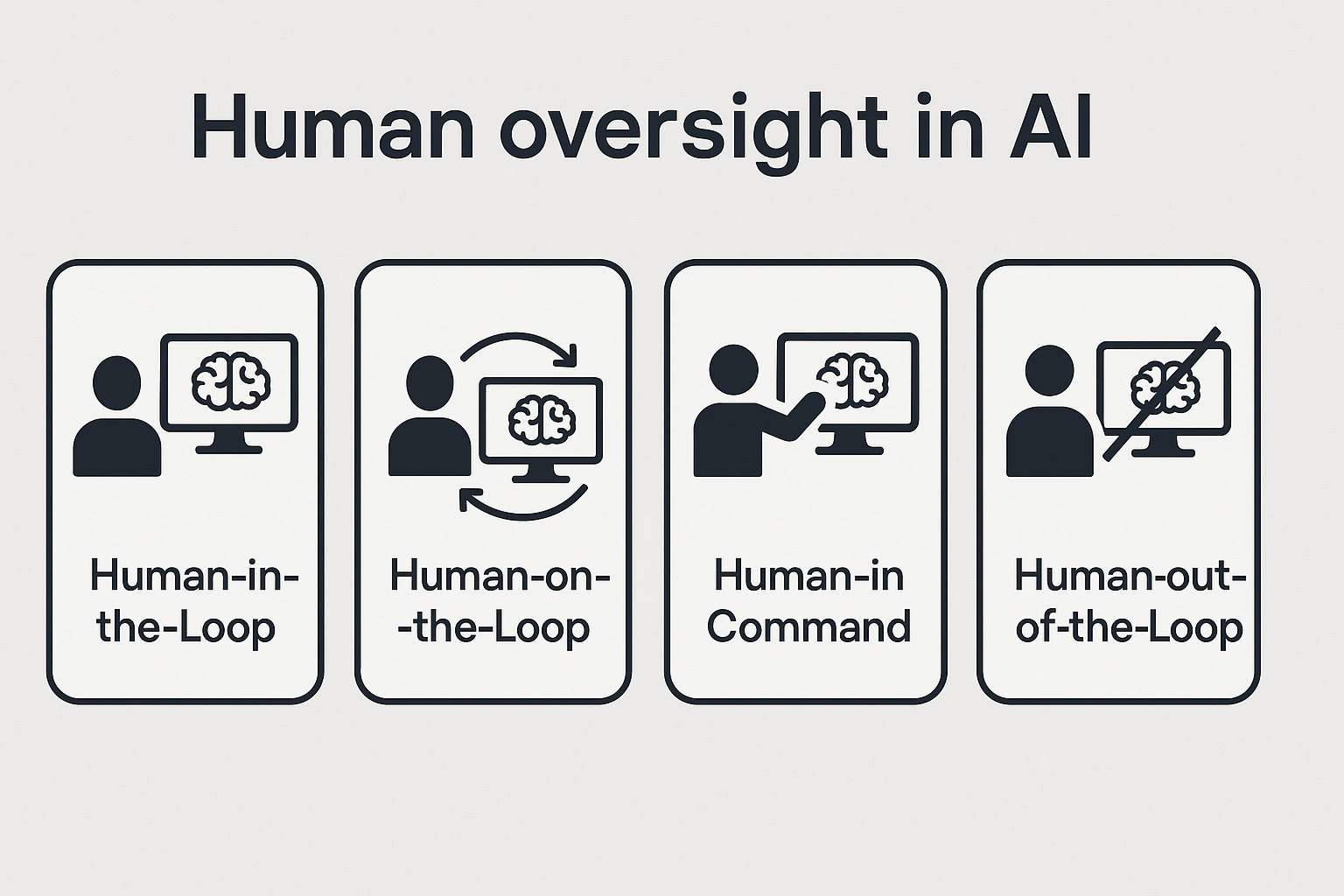

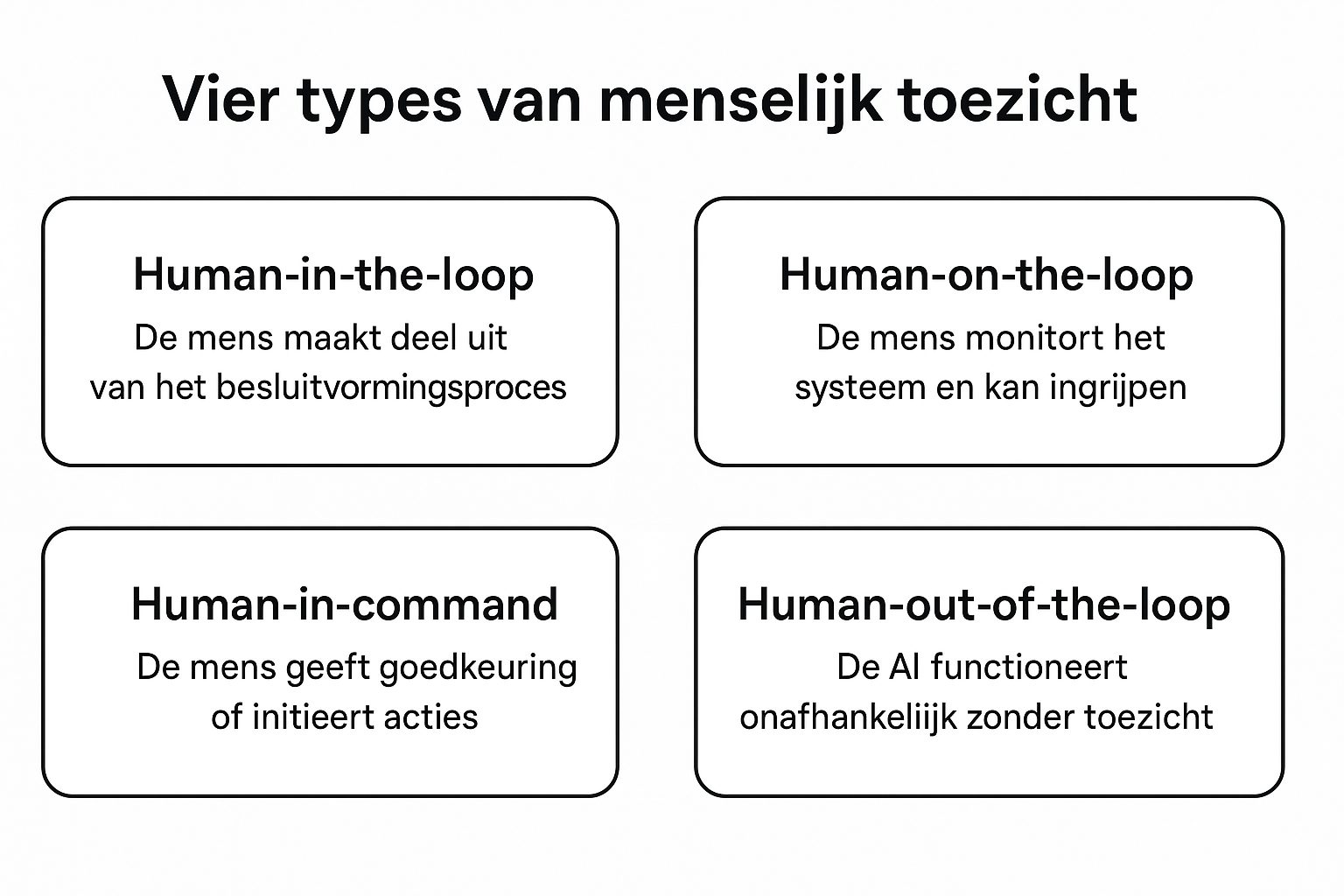

De Europese AI Act verplicht menselijk toezicht bij hoog-risico systemen. Dat toezicht kan op verschillende manieren worden ingericht:

De mens en AI werken samen als co-piloten

De mens en AI werken samen als co-pilotenHuman-in-the-loop (HitL)

De mens neemt altijd de uiteindelijke beslissing. AI is een adviesinstrument. Denk aan een radioloog die AI gebruikt om tumoren op scans te detecteren, maar zelf de diagnose stelt. Of een rechter die AI gebruikt om jurisprudentie te analyseren, maar zelf de juridische conclusie trekt.

Human-on-the-loop (HotL)

AI werkt grotendeels zelfstandig, maar de mens houdt toezicht en kan ingrijpen. Bijvoorbeeld: een zorgrobot die zelfstandig monitort, maar de verpleegkundige waarschuwt bij afwijkingen. In de industrie worden robots ingezet onder menselijk toezicht voor gevaarlijke processen.

Human-in-command (HiC)

De AI voert alleen acties uit als de mens dat expliciet goedkeurt. Denk aan een drone die pas opstijgt na menselijke autorisatie. Ook bij geautomatiseerde wapensystemen is deze controle essentieel om escalatie te voorkomen.

Human-out-of-the-loop (HootL)

De AI functioneert volledig autonoom. Zoals algoritmes op de beurs die in milliseconden handelen zonder menselijke tussenkomst. Risicovol, zeker als dingen misgaan. Dit model wordt steeds vaker bekritiseerd vanwege de ethische en juridische oncontroleerbaarheid.

Deze modellen zijn niet waardevrij: ze zeggen iets over onze rol in technologie. Willen we regisseurs zijn of passieve toeschouwers?

4. Strategieën om controle te behouden

Controle vraagt om meer dan alleen een stopknop. Enkele effectieve strategieën:

| Strategie | Doel | Concrete Voorbeelden | Menselijke Input | AI Output |

|---|

| Ontwerp voor samenwerking | AI als assistent, niet als vervanger | Juridisch AI-systeem dat relevante jurisprudentie voorstelt | Advocaat formuleert zoekvraag en beoordeelt relevantie | Voorgestelde zaken en argumenten |

| Beperk afhankelijkheid | Kritisch denken stimuleren | Navigatie-app met meerdere routes | Bestuurder kiest route op basis van context | 3-4 alternatieve routes met voor/nadelen |

| Maak AI begrijpelijk | Transparantie in besluitvorming | Kredietbeoordelingssysteem | Klant levert financiële gegevens | Uitleg waarom krediet wel/niet wordt toegekend |

| Transparante sociale AI | Duidelijke AI-identificatie | Customer service chatbot | Gebruiker stelt vragen | "Ik ben een AI" disclaimer + gerichte antwoorden |

| Monitoring en feedback | Kwaliteitscontrole | Content moderatie systeem | Moderator beoordeelt AI-beslissingen | Gemarkeerde content met risiconiveau |

| Test in sandbox | Veilige ontwikkeling | Medische diagnose AI | Artsen testen met nepdata | Diagnosevoorstellen zonder patiëntrisico |

Ontwerp voor samenwerking

Laat AI werken als een co-piloot, niet als een vervanger. Geef de gebruiker controle over hoe en wanneer AI wordt ingezet. Een juridisch AI-systeem kan bijvoorbeeld suggesties doen, maar niet automatisch juridische conclusies trekken. In de zorg kunnen AI-systemen dienen als diagnose-assistent, maar niet als vervanging van de arts.

Beperk afhankelijkheid

Laat gebruikers eerst zelf nadenken voordat ze de AI-output zien. Of presenteer meerdere suggesties in plaats van één resultaat. Dit houdt het kritisch denkvermogen actief. Denk aan navigatiesystemen die alternatieve routes tonen in plaats van slechts één optie.

Maak AI begrijpelijk

Leg uit hoe de AI tot zijn conclusie komt, in begrijpelijke taal. Vermijd blind vertrouwen gebaseerd op autoriteit of precisie. Gebruik visuele uitleg, zoals oorzaak-gevolg grafieken of uitlegvideo's bij output.

Wees transparant bij sociale AI

Maak altijd duidelijk dat de gebruiker met een AI te maken heeft. Bescherm kwetsbare groepen, zoals kinderen of mensen met mentale problemen. Bijvoorbeeld via labels zoals "chatbot" of tijdslimieten op interacties.

Voorzie in monitoring en feedback

Bouw systemen in die ongewenst gedrag detecteren. Laat gebruikers feedback geven, zoals bij content op sociale media. Zo wordt het systeem veiliger en menselijker. Denk aan moderatie-tools met menselijke eindcontrole.

Test in veilige omgevingen

Zelflerende systemen moeten worden getest in sandbox-omgevingen. Laat ze niet los op de echte wereld zonder controlemechanismen. In de gezondheidszorg worden AI's getest op synthetische datasets voor ze patiënten mogen ondersteunen.

5. De AI Act als juridische ruggengraat

De AI Act is het juridische fundament onder veel van bovenstaande principes. Het gaat hierbij niet alleen om abstracte regels, maar om concrete verplichtingen die impact hebben op hoe AI in de praktijk wordt ontwikkeld en ingezet.

Verplichting tot menselijk toezicht (artikel 14)

Stel je voor: een AI-systeem beoordeelt sollicitaties bij een groot bedrijf. Zonder menselijke controle zou een vooringenomen algoritme honderden kandidaten kunnen afwijzen op basis van irrelevante of discriminerende factoren. Artikel 14 verplicht daarom dat een mens toezicht houdt en in kan grijpen, juist om deze fouten te voorkomen.

Transparantie-eisen bij AI-chatbots en deepfakes (artikel 52)

In 2023 ging een deepfake-video van president Zelensky viraal, waarin hij zogenaamd opriep tot overgave. Hoewel nep, verspreidde de video zich razendsnel. De AI Act verplicht dat gebruikers duidelijk worden geïnformeerd wanneer ze te maken hebben met AI-content of chatbots. Denk aan een chatbot van een gemeente: burgers moeten weten dat ze geen mens spreken, zodat ze hun verwachtingen kunnen bijstellen.

Verboden op manipulatieve of exploitieve AI (artikel 5)

Een schrijnend voorbeeld: speelgoed dat kinderen manipuleert om steeds opnieuw aankopen te doen via stemcommando's. Of AI-systemen die ouderen beïnvloeden om dure abonnementen af te sluiten. Artikel 5 verbiedt dit type AI dat misbruik maakt van kwetsbaarheden of gedrag manipuleert zonder dat mensen het doorhebben.

De wet stelt eisen aan ontwerp, gebruik en toezicht, met als doel menselijk welzijn, transparantie en fundamentele rechten te beschermen. Het is geen technische handleiding, maar een ethisch kompas dat organisaties dwingt om verantwoordelijkheid te nemen voor hun AI-systemen.

AI moet de mens versterken, niet vervangen

Controle behouden is geen bijzaak, maar een voorwaarde voor betrouwbare AI. De mens moet aan het roer blijven. Dit vraagt om slim ontwerp, goede wetgeving en een cultuur waarin ethiek, transparantie en samenwerking centraal staan.

De AI Act helpt, maar de echte verandering zit in hoe we AI bouwen, gebruiken en erover nadenken. Technologie is geen neutrale kracht. Het is aan ons om te bepalen of AI ons versterkt – of ons buitenspel zet. Alleen door menselijk toezicht vanaf het ontwerpstadium in te bouwen, kunnen we ervoor zorgen dat AI-systemen niet slechts efficiënt, maar ook rechtvaardig, uitlegbaar en mensgericht zijn.

De mens moet aan het roer blijven bij AI-systemen

De mens moet aan het roer blijven bij AI-systemen De mens en AI werken samen als co-piloten

De mens en AI werken samen als co-piloten